빅 데이터 개요

- 정보 수집

우선 선정된 과제의 키워드를 선정한다. 이것은 일반 사용자 입장에서는 검색어 정도가 되겠다.

선정된 키워드의 데이터를 수집한다. 주로 웹에서 수집할수 밖에 없다. 하나의 도서가 온라인화 되어있지 않다면

이 서적에 포함된 내용은 빅데이터의 내용이 될수없다. 이런 과제를 포털사에서 진행한다면 자사의 데이터

베이스를 소스 데이터로 삼을 수 있을 것이다. 이것은 특수한 경우이도 대부분의 빅데이터의 수집은 현제로서는

웹 문서의 정보 수집이다. 이 웹문서의 내용 수집은 기술적으로는 스크래핑이라는 기술이 사용되어진다.

각각의 프로그램(android,ios,swing,vb,vc,.net등)의 웹뷰를 이용한 자료수집은 적당치 않다. android,ios는 우선

현재의 최상위 스펙조차도 웹데이터의 수집에 적당치 않다. 응용 프로그램의 웹뷰를 이용하면 각 수집 대상이

되는 웹 화면의 로딩이 끝날때 까지 기다려야하는 단점이 있으나 로그인후 정보 수집도 가능해 편리하나 역시

스피드가 큰 이슈이다. 웹뷰없이도 웹 데이터를 수집할수는 있으나 수집 대상의 웹사이트들에서 여러가지 목적으로

이를 막고있다. 웹뷰처럼 화면의 로딩의 대기 없이 웹 소스만 수집하는 커멘드 방식의 웹 정보 수집의

기술이 무었보다도 중요하게 되었다. 자사를 이런 기술을 이용하여 신속한 데이터 수집을 진행하고 있다.

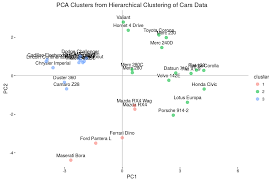

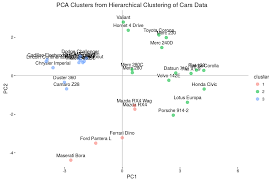

- 정보의 분석

Hadoop R TENSORFLOW 을 가동하여 형대소 단위의 중복 데이터의 수치를 만드는 작업이 필요하다. 여기서 필요 없는 데이터를 걸러 내고

연관어 끼리 모으는 작업이 필요하다 여기서부터 인문학과 기술의 만남이 시작된다고 볼수 있다. 자료을 수집하면 필요 없는 방대한 쓰레기 데이터의

처리에 프로젝트 시간을 다 소비되는것을 방지하는것이 중요하다. 자사는 이런 필요없는 데이터의 삭제를 자동화에 성공하여 실제 프로젝트에 반영하고

있다.

- 결과의 분석

인문학적인 이해가 필요하다. 각각 모아진 데이터 수치를 분석하는일은 인문학에 가깝다.